Detrás del algoritmo: así se crea la inteligencia artificial

¿Quién está detrás del diseño e implementación de los algoritmos y modelos de inteligencia artificial que rigen, cada vez más, nuestras vidas? ¿Qué procesos se siguen para su implementación y gobernanza?

Dice ChatGPT que los algoritmos son “los arquitectos silenciosos de nuestra vida cotidiana”. Es una buena metáfora, que transmite cómo estas fórmulas rigen no solo nuestra vida digital sino buena parte de nuestras interacciones y procesos analógicos e híbridos. Su poder radica en su ubicuidad e influencia, y a menudo en su invisibilidad.

Hasta la llegada de la inteligencia artificial (IA) generativa este concepto era aún un gran desconocido, pero incluso ahora que se ha colado en nuestro vocabulario estamos lejos de entender qué son y qué hay detrás de los llamados algoritmos. ¿Quiénes los diseñan y cuál es su proceso de creación, implementación y gobierno?

El “qué”

Un algoritmo es un conjunto de reglas matemáticas que ayudan a calcular la respuesta a un problema o a realizar una tarea específica. Los hay más o menos sofisticados, y los de inteligencia artificial son solo un subtipo, dentro del cual hay muchos otros. Por ejemplo, un algoritmo de aprendizaje automático -que es una técnica de IA- consiste en una serie de instrucciones que se ejecutan en conjuntos de datos (datasets) para reconocer patrones.

A su vez, un modelo de inteligencia artificial es el resultado de entrenar un algoritmo con ese dataset. O, dicho de otra manera: un algoritmo es lo que se utiliza para entrenar un modelo. Funciona como un programa que, dada una entrada, proporcionará una salida. Este será diferente tanto si se cambia el dataset (aunque se utilice el mismo algoritmo), como si se cambia el algoritmo (aunque se utilicen los mismos datos).

¿Y en qué consiste eso de entrenar un algoritmo? Pues básicamente en alimentarlo de datos y en proporcionar retroalimentación para crear y mejorar las reglas del modelo. Es una tarea que, en modelos grandes como los de la IA generativa, puede suponer miles de horas de trabajo. El objetivo es ‘enseñar’ al algoritmo cómo sería el resultado ideal, es decir, qué salida se espera para cada tipo de entrada, de forma que pueda ofrecer mejores predicciones. Esas predicciones pueden variar: categorizar imágenes, interpretar el significado de frases, etc.

Por ejemplo, ChatGPT Plus se basa en el modelo GPT-4, la cuarta generación de los llamados ‘grandes modelos de lenguaje’ (LLM en inglés), capaz de procesar entradas en forma de imágenes y texto, y de producir salidas de texto. Este LLM -simplificando mucho- se basa, a su vez, en varios tipos de algoritmos: de procesamiento de lenguaje natural y de imagen, de traducción, de generación de texto, etc. En cuanto al dataset, se estima que contiene aproximadamente un petabyte de datos (algo así como 300 millones de fotos digitales de calidad razonable) o incluso varios.

El trabajo de entrenamiento normalmente lo realiza un científico de datos, que en su analogía deportiva podría ser el entrenador de un atleta (el algoritmo) a partir de datos como sus registros de rendimiento anteriores, su régimen, etc. (el conjunto de datos usado).

Los datos usados pueden ser tanto etiquetados como no etiquetados. Los primeros están anotados con palabras que identifican sus características, propiedades, clasificaciones u objetos específicos. Por ejemplo, en la categoría animales, las imágenes podrían etiquetarse como perros, gatos o pájaros. Los datos no etiquetados son lo opuesto, y la ausencia de etiquetas obliga al modelo a evaluar cada ítem según sus características, como el color y la forma.

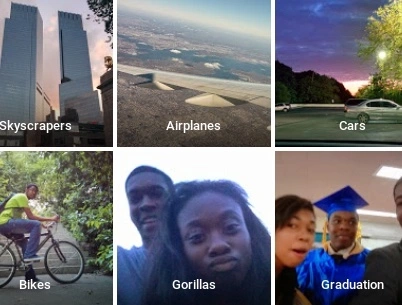

Todas estas tareas son cruciales para la precisión de un sistema. Un mal entrenamiento, un mal etiquetado y un mal set de datos pueden llevar a errores tan mediáticos como los del sistema de visión artificial que siguió la calva del árbitro en lugar de a la pelota en un partido de fútbol en 2020. O como el fallido algoritmo de Google Photos, que etiquetó como “gorilas” a la programadora Jackie Alcine y a un amigo (ambos afroamericanos). Sucedió en 2015 pero el problema persiste, tal y como reveló una investigación reciente de The New York Times.

El “quién” (inventa)

Los cerebros detrás de estos algoritmos pueden venir de las matemáticas, la informática, la física… y, al contrario de lo que se cree, no son los programadores. “Son normalmente investigadores que están en proceso de doctorarse o que se doctorado ya”, afirma Ariadna Font, exdirectora de ingeniería de la plataforma de aprendizaje automático de X (cuando aún se llamaba Twitter).

“Para lograr desarrollar algo que sea eficiente y que funcione mejor de lo que ya existe hay que diseñar muchos experimentos con una metodología muy específica que requiere ese tipo de preparación, y cuyo resultado se publica en una revista científica”, explica Font, que ahora está creando una empresa -Alinia- cuyo objetivo es que las organizaciones puedan usar modelos LLM de código abierto de manera fiable y responsable.

Entonces, ¿qué hacen los desarrolladores o ingenieros de software? “Se dedican a tratar de optimizar algoritmos y modelos que ya se han descubierto, y a implementarlos”, señala la experta. Es un trabajo colaborativo. En una plataforma como X hay personas trabajando en diferentes aspectos, que además implican cientos e incluso miles de algoritmos y de modelos.

“El algoritmo que te permite ver notificaciones en tu teléfono es diferente del que te las envía a tu correo electrónico. Estos, además, pueden aprender, adaptarse y evolucionar. Es un sistema muy complejo”, apunta Font. De hecho, solo los algoritmos para sistemas de recomendación (como los de las redes sociales, buscadores, plataformas de streaming, etc.) son en sí un mundo, con conferencias anuales que reúnen a miles de investigadores a escala internacional para resolver los retos más acuciantes en el campo.

El “cómo”: el caso de Hugging Face

¿Qué proceso se sigue desde que se inventa o concibe un algoritmo hasta que se pone en marcha, se implementa y se libera al mundo? ¿Quiénes intervienen? Las posibilidades son tantas como el tipo de organización. Exploramos el caso de la empresa Hugging Face -que ha desarrollado varios modelos LLM de código abierto- de la mano de su exasesor de Asuntos Técnicos y Regulatorios, Carlos Muñoz Ferrandis.

Lo primero que hay que explicar es que, frente al modelo cerrado de OpenAI con GPT-4, la aproximación de Hugging Face en sus proyectos BigScience o BigCode es abierta. “En un proyecto de este tipo, la comunidad se reúne y pone en común esfuerzos tanto para el desarrollo como para la gobernanza del modelo”, explica Muñoz. Dicha comunidad consiste en una serie de personas que contribuyen de manera voluntaria al proyecto, o esponsorizadas por Hugging Face o por otras empresas o instituciones de investigación (por ejemplo, el Alan Turing Institute, en Reino Unido).

¿Qué comprende el desarrollo de un modelo? El experto -socio de Font en Alinia- explica que este proceso incluye la recolección de datos para el entrenamiento; el diseño de la arquitectura; el entrenamiento del modelo, y otras etapas anteriores a la puesta a disposición del público en su repositorio abierto.

Este tipo de proyecto se divide en diferentes grupos de trabajo, que en su caso son esencialmente cuatro: el de dataset, el de entrenamiento, el de evaluación y el de gobernanza. En el caso de BigCode, la labor del primer equipo -compuesto por empleados de Hugging Face y de ServiceNow- era construir el conjunto de datos previo al entrenamiento. Involucró a dos personas a tiempo completo y una tercera para realizar una tarea de procesamiento llamada “deduplicación”. Además, otras 10 personas (cifras aproximadas) se ocupaban de crear conjuntos de datos adicionales, algunas de ellas manejando datos personales, seguridad, exclusión voluntaria, etc.

En el segundo grupo, el de Entrenamiento (que entrena el algoritmo y el modelo, como se explica más arriba en este artículo) participaron entre 4 y 6 personas, también de Hugging Face y de Service Now. Trabajaban en el marco de entrenamiento y en la arquitectura del modelo. “El objetivo era combinar todos los avances actuales y asegurarnos de que podamos realizar este trabajo lo más rápido posible”, asegura Muñoz.

El equipo de Evaluación son entre 5 y 10 personas que participaron en la determinación de cuáles son buenas métricas y puntos de referencia para evaluar el algoritmo y el modelo final, con muchos puntos de control para facilitar el trabajo.

Por último está el grupo de Gobernanza, que hasta hace unos meses lideraba el propio Muñoz. Se encargó de desarrollar los mecanismos para gobernar el modelo, en el marco de su entrenamiento y puesta a disposición al público. Este proceso incluyó la redacción de los términos de uso del modelo, los mecanismos técnicos de filtros de datos personales, la licencia, etc. El equipo estaba compuesto por unas 6 a 8 personas, trabajando en paralelo al desarrollo del proyecto de principio a fin. Un proceso así puede durar unos 7-8 meses, como fue el caso de Big Code.

En este proceso, el equipo de Muñoz publicó tres documentos clave. Uno es su Carta de gobernanza, que describe los diferentes mecanismos y áreas de gobernanza en el proyecto BigCode. Incluye información sobre las decisiones tomadas durante el proceso, y otros datos como la huella de carbono del algoritmo o lo que pagan a empresas externas de etiquetado de datos. Este último es un asunto que ha traído dolores de cabeza a empresas como OpenAI, tras descubrirse que la empresa subcontrató a trabajadores kenianos por menos de dos dólares por hora para hacer que ChatGPT fuera menos tóxico, es decir, para evitar respuestas violentas, sexistas y racistas.

Junto con la Carta de gobernanza de BigCode, en otros proyectos como BigScience está su Carta ética: una guía para la toma de decisiones en cuanto a la gobernanza del modelo. Su elaboración fue producto de una investigación sobre la articulación entre la ética, la regulación y el desarrollo técnico en este tipo de proyectos. “Se rige por unos valores que han llevado, por ejemplo, a incluir restricciones de uso y ciertas obligaciones dentro de la licencia”, afirma el experto. Por ejemplo, no se permite emplearlo para ofrecer recomendaciones médicas, y se obliga a comunicar a cada usuario que el resultado ha sido generado por un sistema de IA.

Por último, el tercer documento relevante es el que recoge la documentación de todo el proceso de desarrollo del modelo y que está disponible en abierto. “Mucha gente lo que quiere es tener acceso al desarrollo del modelo, por el mero hecho de saberlo, para aprender, para mejorarlo, evaluarlo…”, afirma Muñoz.

El “quiénes” (implementan)

El talento en este proceso de implementación es pluridisciplinar. Involucra ingenieros de aprendizaje automático y, dentro de estos, especialistas en entrenamiento de modelos fundacionales, de etiquetado (científicos de datos), etc. También requiere de especialistas en legal para diseñar los mecanismos de gobierno y los términos de uso; de eticistas para asegurar un desarrollo ético; de expertos en sostenibilidad para trazar la huella de carbono de los algoritmos…

¿Y qué hay de los diseñadores y de los equipos de experiencia de usuario? En proyectos como BigScience o BigCode no tienen mucha presencia, ya que su objetivo no es comercializar los modelos sino abrirlos para que otras personas y organizaciones los usen. En el caso de otras empresas con modelos propietarios -como OpenAI- estos equipos sí juegan un papel esencial. Vamos a verlo con el caso de la empresa Narrativa, pionera en la generación de contenido automatizado en España.

“Narrativa trabaja con 55 medios de comunicación de todo el mundo y con empresas de la industria farmacéutica, banca y gobierno”, asegura su fundador y director general, David Llorente. Su modelo consiste en licenciar su plataforma de IA generativa, basada en versiones reentrenadas de modelos como Llama 2 (el modelo LLM de código abierto de Meta).

Llorente explica que el proceso de reentrenamiento lo realizan sus ingenieros de aprendizaje automático. Su trabajo es crear buenos dataset sintéticos. ¿En qué consisten? Llorente lo ejemplifica con el caso de la industria farmacéutica. “Un problema en este sector es que los médicos, al describir los síntomas de un paciente, a veces no usan los términos estandarizados”, comenta. “Lo que hacen los ingenieros de IA usar los diccionarios de la industria junto con el modelo (aún no reentrenado) para generar variaciones de la misma palabra”, prosigue el experto. Con esas variaciones confeccionan el dataset sintético que luego usarán para reentrenar el modelo. Así, cuando este tenga una entrada que sea una de esas variaciones o similar, podrá saber qué se está refiriendo y generar una salida adecuada.

Además de estos ingenieros, ¿qué otros perfiles son clave en la empresa? Más ingenieros: de sistemas, de infraestructura y programadores. Son 12 personas en total. Pero además, en el caso de Narrativa, sí es muy importante el equipo encargado de desarrollar la experiencia de usuario (lo que se conoce como ‘UX’) y de optimizar la satisfacción de sus clientes. Son cuatro personas, que se encargan de diseñar las aplicaciones e interfaces que usarán estos y de garantizar que cumplen con sus expectativas. También hay una persona encargada de liderar el producto -la plataforma- en sí.

“Otro perfil clave es el de Cumplimiento legal, dado que estamos trabajando en industrias reguladas y con contratos privados”, señala Llorente. Es una persona cuyo trabajo es garantizar que su plataforma y tecnologías están alineadas con la regulación existente, incluidos aspectos como la privacidad, la ciberseguridad, la responsabilidad de cada paso en cada proceso, a quién debe reportar cada persona, etc. Es un perfil equivalente al de Gobernanza en Hugging Face.

Aparte de esto, cuentan con dos personas para comunicación y marketing. Algunas otras tareas las externalizan. Por ejemplo, aunque cuentan con varias personas especialistas en diferentes dominios (medios de comunicación, salud…) a veces es necesario implicar a expertos independientes adicionales. En otras ocasiones, codiseñan sus soluciones junto con sus propios clientes, empresas del sector que aportan dicha experticia.

Responsabilidad humana

En esto consiste, grosso modo, el proceso de creación, desarrollo e implementación de sistemas algorítmicos en la práctica. Queda claro -y es importante no olvidarlo- que cada algoritmo es el resultado de una serie de decisiones humanas. Su diseño refleja tanto las necesidades del contexto en el que surgen como las intenciones de sus creadores y sus prejuicios.

Asimismo, en los conjuntos de datos entrenamiento se embeben también los sesgos de quienes seleccionan dichos datos, los sesgos históricos contenidos en ellos, y los sesgos propios del mundo en el que operan los modelos. Como consecuencia, estos a menudo automatizan las desigualdades y perpetúan la discriminación por raza, género, religión, ingresos, capacidades o tendencia sexual. Crean ciclos de retroalimentación que perpetúan la injusticia. Y, dado que se están utilizando para tomar decisiones importantes en muchos sectores, tienen un poder creciente sobre la acción humana, incluso por encima de ella: se objetivizan con la supuesta imparcialidad de los números.

Estos sistemas con problemas intrínsecos de clasificación y sesgos son los que Cathy O’Neil denomina “armas de destrucción matemática”, que gobiernan el acceso y exclusión a la información y a las oportunidades, juzgan y toman decisiones de forma arbitraria. En sus versiones más avanzadas son, además, cajas negras: sistemas opacos cuyo proceso y razones para obtener resultados específicos no son completamente comprensibles para los humanos. Esta condición es particularmente importante para garantizar la equidad en el uso de algoritmos y para identificar posibles sesgos en los datos de base.

Las personas involucradas en el diseño, desarrollo e implementación de modelos algorítmicos deben asegurarse de que estos no solo sean eficientes y efectivos, sino también justos, explicables y éticos. Sin embargo, esto a menudo no sucede, o se hace de forma superficial e insuficiente. Sin ir más lejos, este mismo año Amazon (a través de Twitch), Microsoft y Meta han realizado sustantivos recortes en sus equipos de IA responsable y ética, y en muchos casos no solo los han diluido sino que también los han dispersado y atribuido otras responsabilidades. Otros como X -tras la llegada de Elon Musk- los han eliminado por completo, como es el caso del equipo de Ética, Transparencia y Rendición de Cuentas que estaba bajo supervisión de Font.

A estos problemas se añade el de las condiciones laborales de los trabajadores detrás del desarrollo e implementación de algoritmos y modelos, y también de quienes se dedican a moderar contenido sensible que al modelo se le ha pasado por alto. Este último caso se da específicamente en plataformas como las redes sociales o como YouTube.

En 2018, moderadores de Facebook decidieron demandar a la empresa por no protegerles de un posible trauma mental. Denunciaban ser bombardeados con miles de vídeos, imágenes y transmisiones en vivo de abuso sexual infantil, violación, tortura, bestialidad, decapitaciones, suicidio y asesinato. En 2020, Facebook acordó pagar 52 millones de dólares a un total de 11.250 personas que ejercían el trabajo en ese momento o lo habían ejercido con anterioridad.

El desarrollo de sistemas de inteligencia artificial seguirá enfrentándose a estos retos, y a otros como la atribución de responsabilidad cuando un modelo de IA falla. Esta no puede ser del algoritmo ni del modelo, que es un producto informático inerte, sino de las personas de carne y hueso que están detrás de su invención y despliegue.

Algunos de estos desafíos se abordan en regulaciones ya en efecto en Europa (como la Ley de Servicios Digitales) o en proceso de aprobarse, como la Ley de IA. Son leyes –aunque imperfectas– diseñadas con el propósito de salvaguardar los derechos de la ciudadanía y de canalizar el desarrollo tecnológico hacia el bien común.

También se abren oportunidades profesionales en estos ámbitos: el de la regulación y la gobernanza de la IA, y el de la búsqueda de nuevos algoritmos y modelos que contribuyan a luchar contra grandes retos en materia de salud, medio ambiente, educación, desigualdad, etc. Siempre, eso sí, siendo conscientes del alcance de estos sistemas y de sus límites. Conocer en qué consisten; cómo se crean, desarrollan e implementan, y quién está detrás de ellos, ayuda a poner los pies en la tierra.